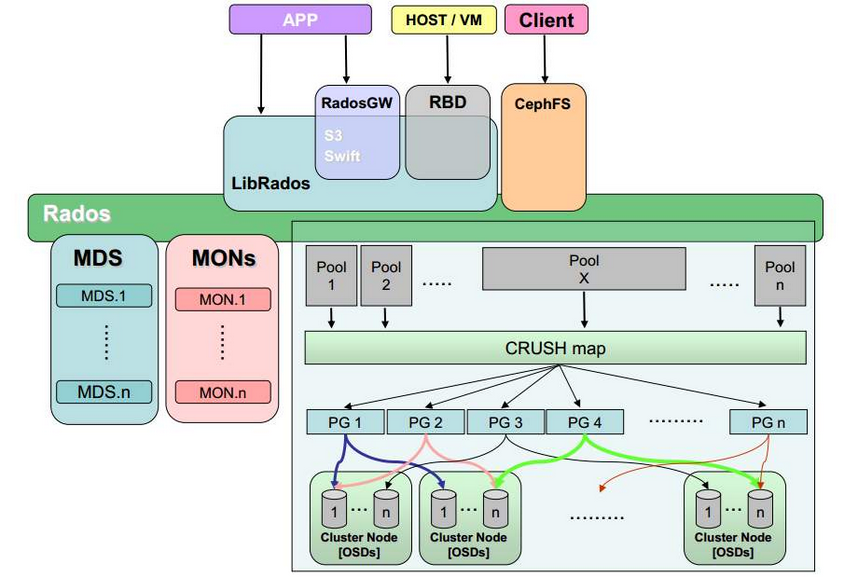

Ceph架构 白话解释:Ceph底层是一个RADOS系统(可靠,自动,分布的对象存储系统),RADOS提供对数据的一致性,高可用性,可靠性等功能。通过CRUSH map的算法来提供数据的均衡性(使文件可以合理的分配到OSD中)。再此之上我们会建立Pool池对不同空间下的文件进行隔离。Pool对通过LibRaods接口映射出三个文件系统(对象存储,块存储和文件存储)提供按需的使用。Mon保存OSD元数据。MDS保存CephFS文件系统的元数据。

官方文档:https://docs.ceph.com/en/latest/start/intro/

官方对各名词的解释

OSD:OSD全称Object Storage Device,也就是负责响应客户端请求返回具体数据的进程。一个Ceph集群一般都有很多个OSD。

Mon:一个Ceph集群需要多个Monitor组成的小集群,它们通过Paxos同步数据,用来保存OSD的元数据。

MDS:MDS全称Ceph Metadata Server,是CephFS服务依赖的元数据服务。

PG:PG全称Placement Grouops,是一个逻辑的概念,一个PG包含多个OSD。引入PG这一层其实是为了更好的分配数据和定位数据。

RADOS:RADOS全称Reliable Autonomic Distributed Object Store,是Ceph集群的精华,用户实现数据分配、Failover等集群操作。

LibRados:Librados是Rados提供库,因为RADOS是协议很难直接访问,因此上层的RBD、RGW和CephFS都是通过librados访问的。

CRUSH map:Ceph使用的数据分布算法,类似一致性哈希,让数据分配到预期的地方

RBD:RBD全称RADOS block device,是Ceph对外提供的块设备服务。

RGW:RGW全称RADOS gateway,是Ceph对外提供的对象存储服务,接口与S3和Swift兼容。

CephFS:CephFS全称Ceph File System,是Ceph对外提供的文件系统服务。

PG:placement group硅脂组,每个OSD上最多可以创建250个PG。默认情况下,每个PG有三个副本,所以每个OSD推荐创建的PG数为80。

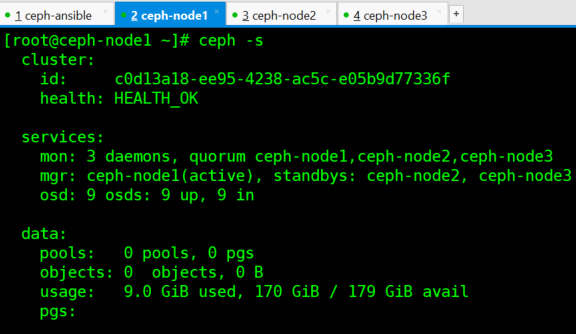

我们用ceph -s命令来查看ceph集群的状态

cluster id:集群id

health:集群健康状态

services:mon状态 mgr状态 osd状态

data:pool池个数 objects个数 空间使用量 pg使用量